카카오, 깃허브 통해 ‘Kanana Nano 2.1B’ AI 모델 오픈소스 배포

카카오는 AI 기술의 접근성을 높이고 국내 AI 생태계를 활성화하기 위해

자체 개발한 AI 언어모델 ‘Kanana Nano 2.1B’ 를 오픈소스로 공개했다고 27일 밝혔다.

이번 공개를 통해 연구자와 개발자들은 깃허브(GitHub)를 통해

‘Kanana Nano 2.1B’ 의 베이스 모델, 인스트럭트(Instruct) 모델, 임베딩(Embedding) 모델을

자유롭게 활용할 수 있게 됐다.

‘Kanana Nano 2.1B’는 연구 및 개발 환경에서 활용하기 적절한 크기의 모델이며,

온디바이스(On-device) 환경에서도 뛰어난 성능을 발휘할 수 있도록 설계됐다.

지난달 카카오 테크 블로그를 통해 공개된 테스트 결과에서도

한국어와 영어 처리 능력에서 우수한 성능을 입증했다.

카카오는 이번 오픈소스 공개를 계기로 AI 연구자와 개발자들이

다양한 응용 기술을 개발할 수 있도록 지원하며,

지속적인 모델 업데이트를 통해 기술 고도화를 이어갈 계획이다.

아울러 카카오는 AI 연구 성과를 담은 테크니컬 리포트를 아카이브(ArXiv)에 공개했다.

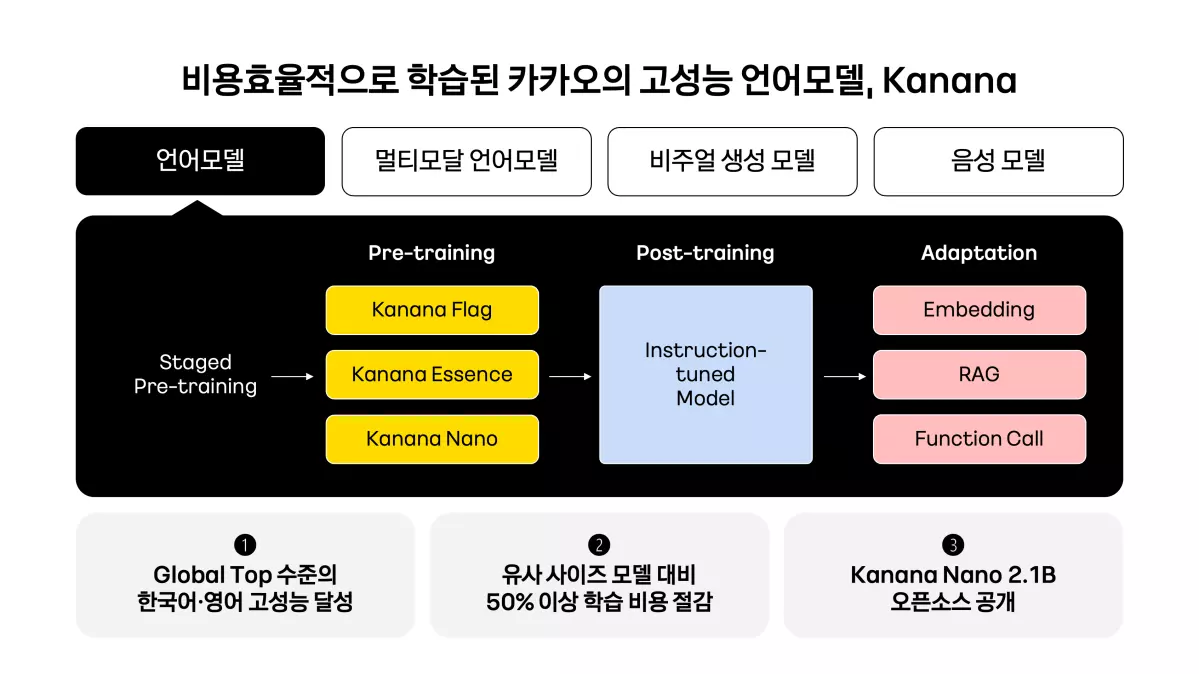

이 리포트에는 카나나 언어모델의 사전 학습(Pre-training)부터

후속 학습(Post-training)까지 전 과정이 상세히 담겨 있으며,

학습 데이터와 모델 구조, 글로벌 벤치마크 성과 등이 포함됐다.

카카오는 작년 10월 개발자 컨퍼런스 ‘if(kakaoAI)2024’에서

‘Kanana Flag’를 포함한 AI 언어모델 라인업(Kanana Flag, Essence, Nano)을 공개한 바 있다.

특히 ‘Kanana Flag’는 한국어 및 영어 성능을 평가하는

벤치마크 테스트(LogicKor, KMMLU, MT-bench, MMLU)에서

글로벌 AI 모델과 동등한 성능을 기록했다.

학습 자원 최적화를 통해 유사 크기의 모델 대비 50% 이상의 비용 절감 효과를 실현하며,

최고 수준(State-of-the-Art)의 효율성과 성능을 구현했다.

카카오는 AI 모델 학습의 효율성을 극대화하기 위해

Staged pre-training, Pruning, Distillation, DUS(Depth Upscaling) 등

최신 AI 학습 기법을 적용했다.

이를 통해 경량 모델 ‘Kanana Nano 2.1B’부터 초거대 언어모델 ‘Kanana Flag 32.5B’까지

다양한 크기의 모델을 최적화했다.

향후 카카오는 강화 학습(Reinforcement Learning)과

연속 학습(Continual Learning)을 기반으로 AI 모델의 추론, 수학, 코딩 능력을 강화할 계획이다.

또한, 정렬(Alignment) 기술을 고도화해 사용자 요청 수행 정확도를 높이고,

음성·이미지·영상 등 다양한 형태의 데이터를 처리할 수 있도록 지속적인 연구개발을 이어갈 예정이다.

김병학 카나나 성과리더는

“모델 최적화와 경량화 기술을 바탕으로 글로벌 AI 모델과 경쟁할 수 있는 고성능 언어모델을 확보했다”며

“이번 오픈소스 공개를 통해 국내 AI 생태계 활성화에 기여할 것으로 기대한다”고 밝혔다.

신혜연 (karung2@sabanamedia.com) 기사제보

![[영화] 30일 기억을 잃은 부부의 유쾌한 로맨스](https://www.intramagazine.com/wp-content/uploads/2025/04/ChatGPT-Image-2025년-4월-18일-오전-09_44_33-300x200.webp)